En matière de référencement naturel (SEO), de nombreux facteurs influencent le classement d’un site web dans les résultats des moteurs de recherche. L’un d’entre eux est le budget crawl (ou budget d’exploration, en français). Explications.

Qu’est-ce que le budget crawl ?

Le budget crawl représente le nombre de pages maximum que les moteurs de recherche, tels que Google, peuvent explorer et indexer sur un site web donné. Il est limité pour chaque site web afin d’économiser les ressources et les coûts (temps, bande passante, puissance de traitement…) et de ne pas le ralentir (un crawl trop massif peut impacter les performances d’un site, au même titre qu’un nombre important de visiteurs présents en simultané). Le budget crawl est basé sur l’autorité et la crédibilité d’un site, ainsi que sur d’autres facteurs.

Comment optimiser le budget crawl ?

Il existe plusieurs façons d’optimiser le budget crawl d’un site web. En voici une liste non exhaustive :

- Optimiser l’arborescence du site : une architecture de site claire et bien structurée facilite la navigation des robots des moteurs de recherche (et des internautes !). En créant une hiérarchie de pages logique, vous permettez à Google et consorts de trouver et d’explorer facilement vos pages importantes.

- Rédiger du contenu de qualité : on ne le dira jamais assez, la qualité, l’unicité et la valeur ajoutée des contenus sont des facteurs clés pour que les robots des moteurs de recherche explorent et indexent les pages d’un site internet.

- Améliorer le temps de chargement du site : un site lent ne verra que quelques-unes de ses pages crawlées à chaque passage d’un robot, tandis qu’un site performant verra son taux d’exploration augmenter. Il faut donc veiller à minimiser le JavaScript et le CSS, optimiser les temps de réponse au niveau du serveur, compresser les images, etc.

- Mettre à jour régulièrement votre site : plus vous publiez fréquemment de nouveaux contenus ou mettez à jour régulièrement votre site, plus la fréquence de passage des bots Google sera grande. Si vous arrêtez de mettre votre site à jour, les robots vont continuer de venir le visiter mais ne constateront aucune évolution. Au bout de plusieurs visites infructueuses, les algorithmes du predictive crawling (intelligence artificielle pour prédire à quelle fréquence de nouveaux contenus sont publiés sur les sites web) se mettront à jour et les bots viendront moins souvent crawler votre site.

- Travailler le maillage interne : relier les pages et les contenus entre eux aide les moteurs de recherche à identifier les pages les plus importantes de votre site et celles qui abordent des thématiques similaires.

- Limiter au maximum les redirections et éliminer les boucles de redirection : les redirections excessives et les boucles de redirections entravent l’exploration de votre site par les moteurs de recherche.

- Corriger les liens brisés : non seulement ils dégradent l’expérience utilisateur, mais ils gênent l’exploration de votre site.

Comment visualiser l’activité de crawl de Google ?

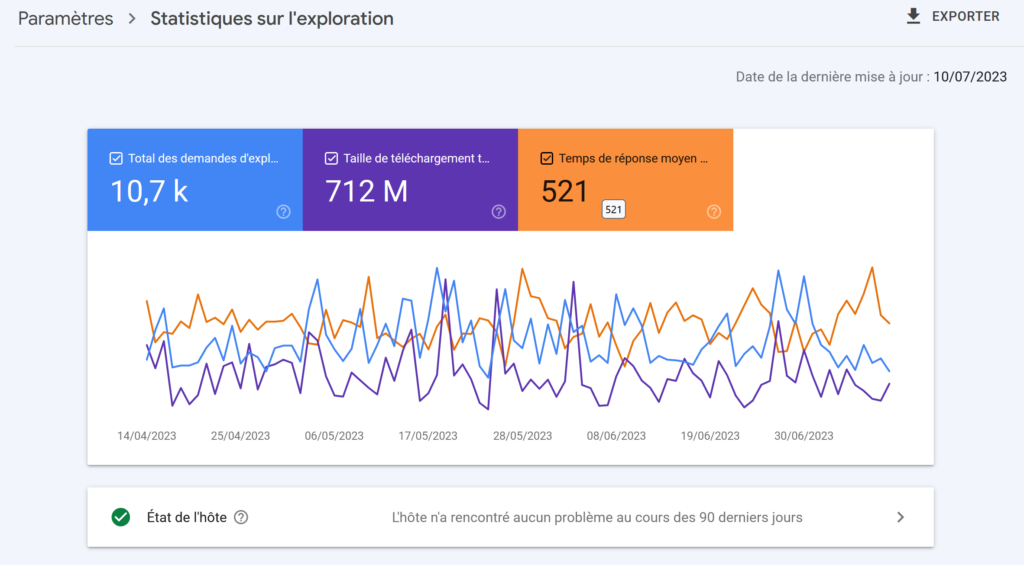

Si vous souhaitez visualiser l’activité de crawl de Google et les éventuels problèmes que les robots auraient identifiés, consultez le rapport de statistiques de crawl dans la Google Search Console.

Lire aussi :

Fréquence d’indexation de Google et priorisation des pages à indexer